FOREXBNB獲悉,野村發佈研報稱,在AI服務器領域,英偉達迄今爲止佔據了超過80%的市場價值份額,而ASIC AI服務器的價值份額約爲8%-11%。另據供應鏈反饋顯示,更多的雲服務提供商(CSP)正在更積極地部署自己的 AI ASIC 解決方案,例如 Meta(META.US)從2026年開始,微軟(MSFT.US)從2027年開始。隨着超大規模雲服務提供商內部需求的成熟(這是特定領域的需求),雲ASIC仍有增長空間,這將挑戰英偉(NVDA.US)達在AI計算集羣中的主導地位。

Meta主要的MTIA項目(尤其是V1.5版本)仍處於開發早期階段,存在諸多不確定性。從供應鏈處瞭解到,Meta計劃到 2026年大規模推進部署,但能否克服上述潛在挑戰尚不明朗。不過,從投資角度看,考慮到當前人工智能行業趨勢(計算能力提升、連接速度加快、功率和熱管理要求提高等),建議佈局多元化客戶覆蓋的潛在受益企業,包括英偉達、AWS Trainium、Meta MTIA 以及谷歌 TPU相關供應鏈。

野村主要觀點如下:

野村發佈研究報告指出,Meta的 MTIA AI服務器可能成爲 2026 年的一個里程碑。

AI ASIC 正蓬勃發展:2026 年下半年至 2027 年有望實現出貨量的超越

在 AI 服務器領域,英偉達(NVDA.US)迄今爲止佔據了超過 80% 的市場價值份額,而 ASIC AI 服務器的價值份額約爲 8%-11%(基於彭博社的共識估計)。然而,如果僅比較 AI ASIC 與英偉達 AI GPU 的出貨量(這可以排除英偉達高達 70-80% 的毛利率所導致的價值偏差),根據供應鏈調查和野村的分析,2025 年,谷歌的 TPU 可能達到 150 萬至 200 萬臺,亞馬遜的 Trainium2 ASIC 可能約爲 140 萬至 150 萬臺,而英偉達準備的 AI GPU 供應量在 2025 年爲 500 萬至 600 萬臺以上(實際銷量可能低於供應量)。

2025 年,谷歌和亞馬遜的 AI TPU/ASIC 的合計出貨量已達到英偉達 AI GPU 出貨量的 40%-60%。

野村的供應鏈反饋還顯示,更多的雲服務提供商(CSP)正在更積極地部署自己的 AI ASIC 解決方案,例如 Meta(META.US)從 2026 年開始,微软從 2027 年開始。AI ASIC 的總出貨量可能在 2026 年的某個時候超過英偉達的 AI GPU。

另一方面,野村注意到英偉達並未坐以待斃,任由定製芯片項目蠶食其市場份額,最終對其在雲 AI 計算領域的主導地位造成重大影響。

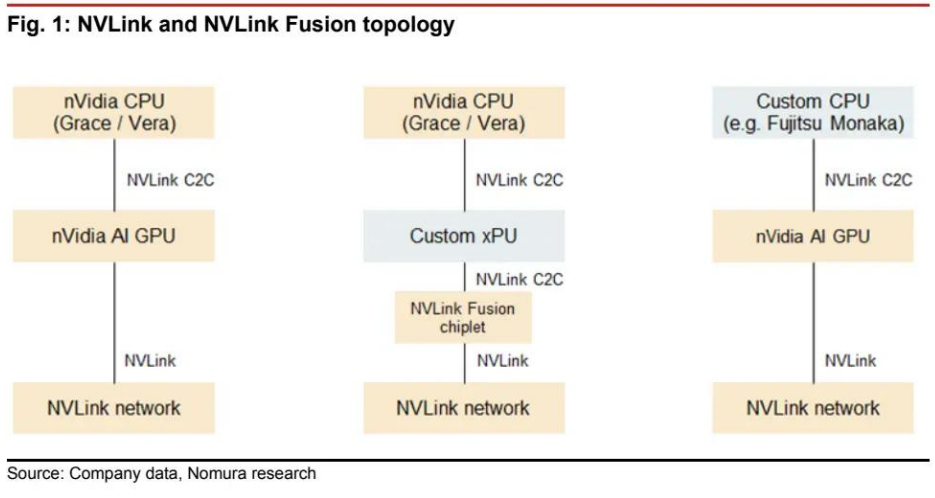

在 2025 年臺北國際電腦展(COMPUTEX 2025)上,英偉達推出了 NVLink Fusion,該技術開放了專有互連協議,支持英偉達 AI GPU 與第三方 CPU 之間,或定製 xPU 與英偉達基於 ARM 的 CPU 之間的芯片间连接(圖 1)。

儘管這種混合架構只是半定製化的,但英偉達正試圖避免完全失去部分雲計算市場,因此雲客戶的最終採用情況和反饋值得關注。

AI ASIC 解決方案對供應商可能意味着更多機會

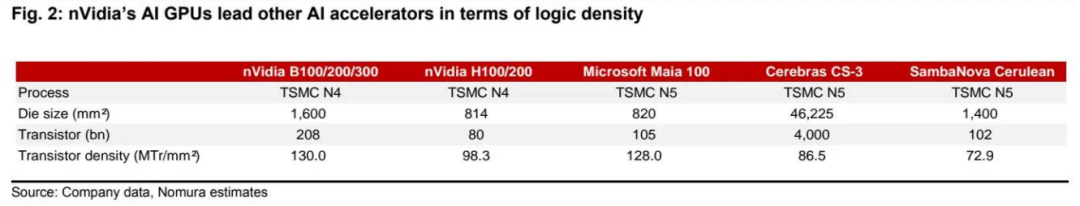

英偉達在 AI 計算領域相對於包括雲 ASIC 在內的其他 AI 加速器的領先優勢正在擴大,部分原因在於:

(1)英偉達的產品在單位芯片面積的計算能力(與邏輯密度相關;圖 2)方面可能優於大多數競爭對手的產品。根据阅存对其产品路线圖的研究,該公司正更加積極地帶頭採用其邏輯代工廠合作伙伴臺積電(TSM.US)(2330 TT,買入評級)的新技術。

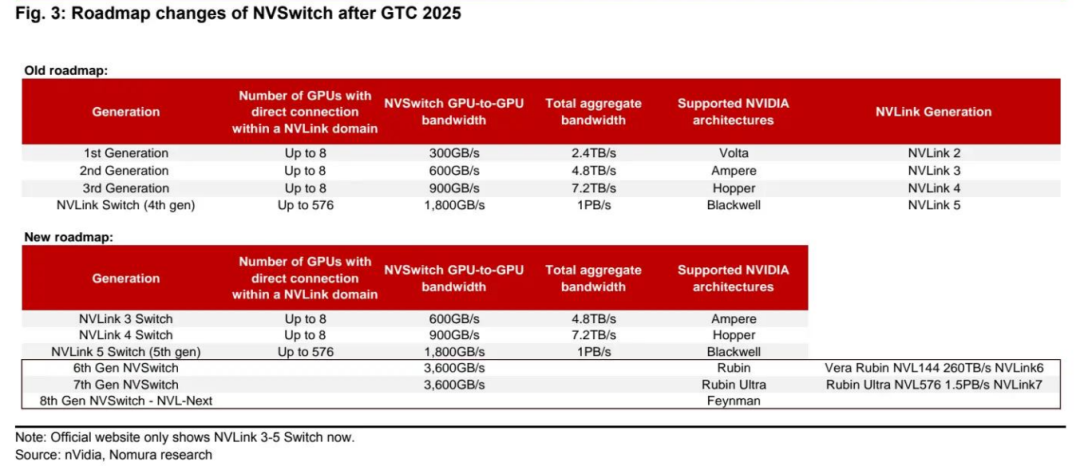

(2)英偉達用於 AI 集羣擴展的互連技術(NVLink)幾乎無可匹敵。野村認爲,儘管業界正在尋求開放規格的 UALink,但到 2026-2027 年,其架構性能仍無法趕上英偉達(圖 3)。

野村注意到,爲了彌補技術性能的不足,與英偉達的解決方案相比,初始的 ASIC 解決方案往往使用更好的材料、組件和效率較低的架構,以確保系統穩定性和性能。這對供應商的附加值有利。然而,儘管物料清單(BOM)成本結構較高,但鑑於 ASIC 解決方案的定製化特性以及消除了英偉達的高系統利潤率,對於雲服務提供商自身的使用而言,ASIC 解決方案可能仍然更具成本效益。

野村認爲,隨着超大規模雲服務提供商內部需求的成熟(這是特定領域的需求),雲 ASIC 仍有增長空間,這將挑戰英偉達在 AI 計算集羣中的主導地位。

野村一直預計,2026 年臺積電的 AI 邏輯半導體收入池中,定製 AI 加速器的增長將比商用 GPU 更爲強勁。

迄今爲止,野村的供應鏈反饋繼續支持這一觀點,但 AI ASIC 的發展正以更積極的姿態擁抱更復雜的規格(例如,用於子系統集成的更大中介層),這超出了市場預期,帶來了驚喜。

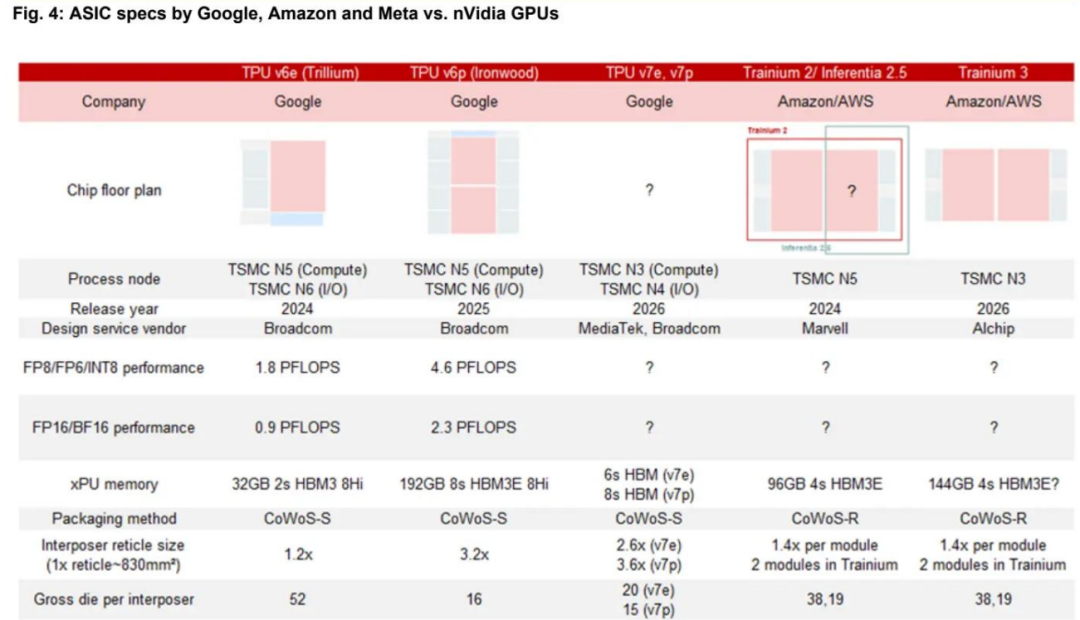

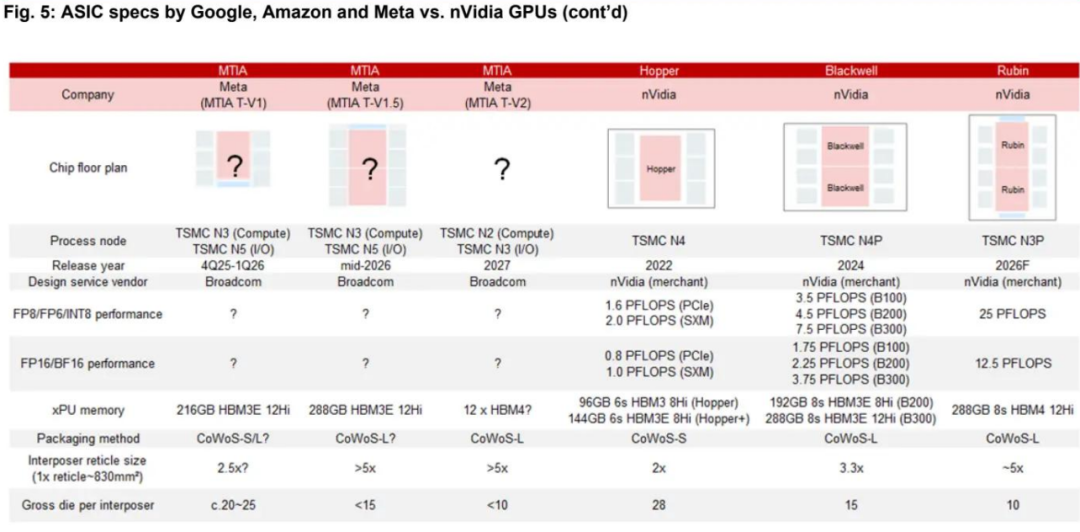

已宣佈的 ASIC 項目,如亞馬遜的 Trainium 和微軟的 Maia 100,過去的特點是 HBM 存儲立方體堆疊數量較少,中介層也比英偉達的 AI GPU 更小(大多不超過 2.5 倍光罩尺寸),但谷歌的 TPU 除外,其設計合作伙伴博通長期以來一直是推動臺積電技術路線圖創新的關鍵客戶。

目前,野村觀察到 AI ASIC 的規格正在追趕英偉達(圖 4 和圖 5),但英偉達在集羣擴展連接性、集羣外連性以及專有的 CUDA 生態系統(最適合企業專屬 AI 解決方案)方面仍具有優勢。

野村還注意到,一些 ASIC 解決方案(例如 Meta 的方案)正試圖利用英偉達的系統架構,有些甚至計劃在未來幾年推出更激進的 ASIC 規格。

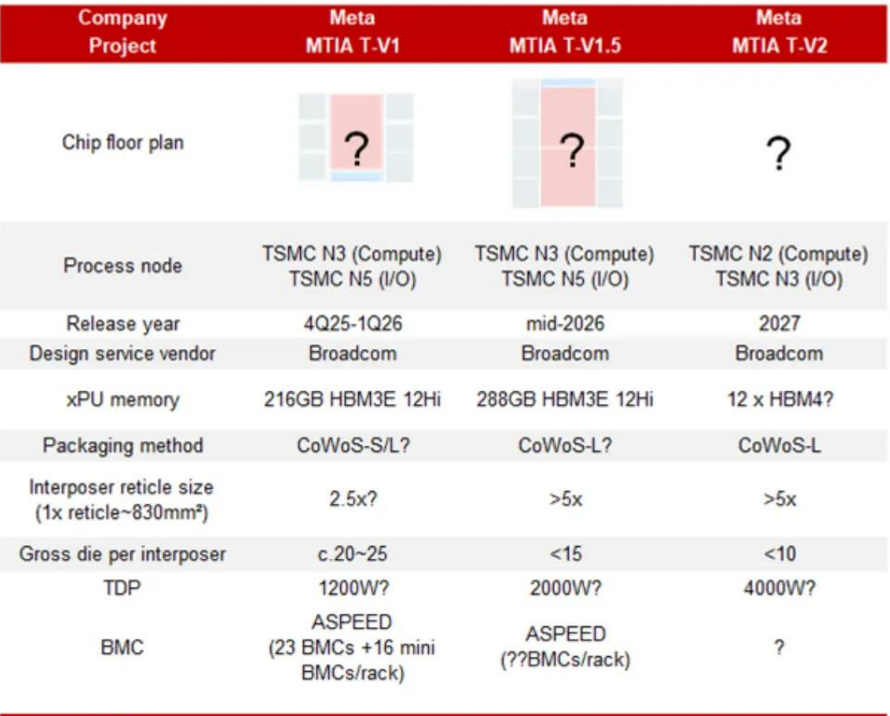

Meta 的 ASIC AI(MTIA)服務器可能在 2026-2027 年以有意義的方式實現規模化部署

野村過去曾強調,Meta 將在 2025 年底前推出首款具有可觀出貨量的 ASIC。現在,野村對其計劃有了更多細節。野村觀察到 Meta 從 2025 年底到 2027 年將推出幾款具有不同系統架構的 MTIA 芯片。在下圖中總結了這些 ASIC 和系統的規格。

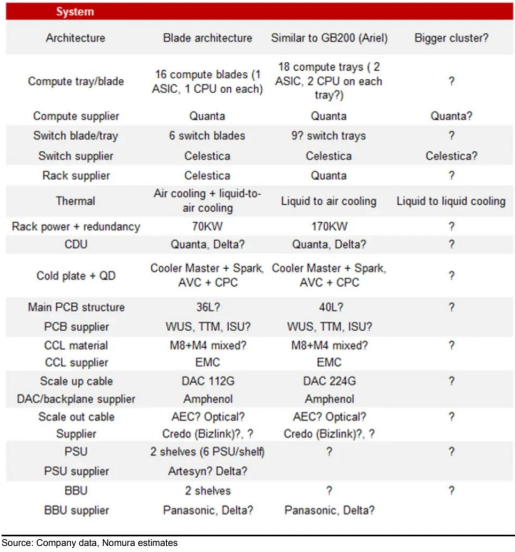

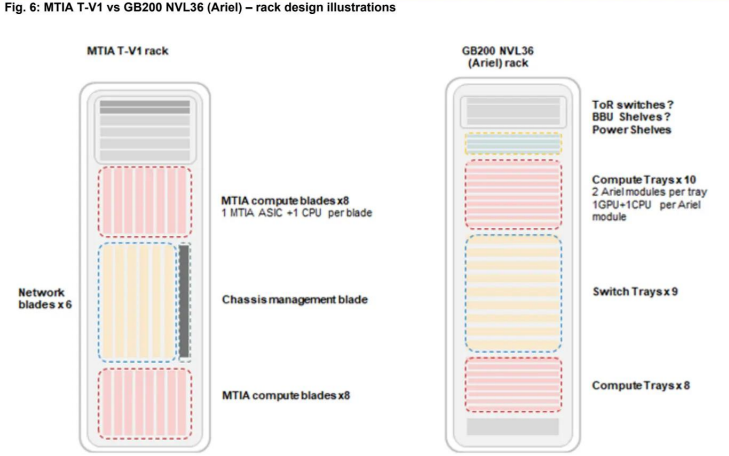

下一款 AI ASIC(MTIA T-V1)將於 2025 年第四季度推出,由博通設計,其中介層尺寸與亞馬遜的 Trainium 2 相似或略小。野村觀察到 Meta 正在利用其在通用服務器中的刀片架構來設計這款 AI ASIC 系統。供應鏈分析表明,該項目由天弘牽頭,計算托盤和 CDU 由廣達製造。機架設計如圖 6 所示。16 個計算刀片和 6 個交換機刀片垂直插入 2 個電纜背板中,通過 DAC 連接。

主要的 ASIC 和交換機 IC 採用液冷,其餘低功耗 IC 和模塊採用風冷。儘管每個計算托盤中只有一個 ASIC 和一個 CPU,但 ASIC 主板的 PCB 設計複雜(儘管尺寸小),採用高等級材料(M8 混合 CCL)和高層數(例如 36 層),這可能是因爲 ASIC 集成了更多功能,需要 PCB 中有更多的信号層,或者电源传输層被分离以确保更低的噪声。此外,可能還採用了 BBU 托盤。

MTIA T-V1.5(V1.5)ASIC 可能在 2026 年中期推出,系統在 2026 年下半年實現規模化部署。MTIA T-V1.5 的芯片性能可能比 V1 強大得多,其中介層尺寸可能是 V1 的兩倍,超過 5 倍光罩尺寸,與英偉達的下一代 GPU Rubin 相似或稍大。儘管 MTIA T-V1.5 系統仍處於採樣初期,但其系統架構更類似於 Meta 的 GB200(NVL36,使用 Arial 模塊 —— 一個 GPU 和一個 CPU,而不是 Bianca—— 兩個 GPU 和一個 CPU)。這解釋了爲什麼 Meta 堅持在 GB200 中使用 Arial 模塊,因爲其單節點、相互備份的架構與之前討論的刀片概念相似。渠道調查顯示,Meta 可能會將 GB200 的組件和設計應用於 V1.5 ASIC 系統。

野村觀察到,作爲 Meta GB200 主要 ODM 廠商的廣達,正在牽頭這個 ASIC 項目,負責計算托盤、機架和 CDU,而天弘可能負責交換機。鑑於 ASIC 的設計更加複雜,計算主板的 PCB 層數可能高達 40 層 HLC PCB,採用混合 M8 CCL(而 Trainium2 主板僅爲 24-26 層 M8 HLC PCB,英偉達採用 M8+M4 混合 HDI+5 層结构)。由於 V1.5 系統的計算托盤和交換機托盤水平放置,其集羣擴展連接性通過 DAC 實現,就像 NVLink Spines 一樣,無需背板箱。V1.5 和 V1 機架均採用液冷轉風冷設計,野村認爲它們與 GB200 和 GB300 共享相同的 CDU 設計和基礎設施,因此 Meta 可以更靈活地在同一基礎設施中安裝不同的系統。

MTIA T-V2 ASIC 可能在 2027 年推出,其 CoWoS 封裝尺寸可能比 MTIA T-V1.5 更大。機架系統可能比 MTIA T-V1.5 機架系統(170 千瓦)大得多。野村認爲,如此高功率的系統可能需要液冷轉液冷的冷卻方式。

元平臺 MTIA 的產量 —— 雄心與潛在挑戰

在博通最新的財報電話會議上,博通重申了至少有三家超大規模客戶預計到 2027 年底將部署 100 萬套 xPU 集羣的預期。

下游供應鏈也認爲,元平臺的目標是到 2025 年末至 2026 年,MTIA V1 和 V1.5 的產量達到 150 萬套,且 V1.5 的產量將遠高於 V1。假設 V1 和 V1.5 的產量分配比例爲 1:2,即 V1 產量爲 50 萬套,V1.5 產量爲 100 萬套(野村的假設是为了简化计算),那麼 2026 年 MTIA 總產量 200 萬套所需的 CoWoS 晶圓約爲 8.5 萬片(主要用於 TPU),這與博通 2025 年 CoWoS 晶圓的可見需求大致相當。

然而,從當前情況看,野村預計 2026 年 MTIA 最多隻能分配到約 3 - 4 萬片 CoWoS 晶圓。要實現 100 萬套以上的產量目標,需要在下游供應鏈中看到更多的 CoWoS 晶圓预订。

MTIA 還面臨其他潛在挑戰。鑑於 ASIC V1.5 的激進規格,其 CoWoS 封裝尺寸較大,這可能是其量產過程中最大的挑戰之一。不確定其大尺寸是否會導致 CoWoS 基板出現問題。更不用說 V1.5 系統在計算功率密度方面與配備博通連接芯片和元平臺架構的 GB200 NVL36 相當。不清楚元平臺是否有足夠時間將系統(包括至少 6 - 9 個月的材料爬坡時間)量產。此外,正如之前強調的,如果 ASIC 爲了彌補性能差距而傾向於使用更好的材料和組件,當 MTIA 大规模量產,且如下游供應商所說的那樣對 AI 晶圓廠(fabs)需求旺盛時,下游材料和組件可能會出現潛在短缺,而這些材料和組件通常也用於 AI GPU 和 ASIC。

投資觀點:

廣達、欣興電子、聯茂電子、勝宏科技和 Bizlink 是 Meta MTIA 項目的潛在關鍵受益者

野村認爲,Meta 主要的 MTIA 項目(尤其是 V1.5 版本)仍處於開發早期階段,存在諸多不確定性。從供應鏈處瞭解到,Meta 雄心勃勃,計劃到 2026 年大規模推進部署,但能否克服上述潛在挑戰尚不明朗。不過,從投資角度看,考慮到當前人工智能行業趨勢(計算能力提升、連接速度加快、功率和熱管理要求提高等),建議佈局多元化客戶覆蓋的潛在受益企業,包括英偉達、AWS Trainium、Meta MTIA 以及谷歌 TPU 相關供應鏈。

對於此前未受充分關注的 Meta 項目,在野村的覆蓋範圍內,廣達、欣興電子、聯茂電子、勝宏科技和 Bizlink 是關鍵受益者:

廣達(Quanta): 作爲亞馬遜雲科技(AWS)、谷歌及 Meta GB200/300 項目的主要原始設計製造商(ODM),廣達还负责 Meta MTIA V1 和 V1.5 的計算托盤及 CDU(冷卻分配單元 )製造,且主導 MTIA V1.5 的整機架組裝。其在英偉達及 ASIC 解決方案領域的多元化佈局,有望助力該公司實現業務再增長。

欣興電子(Unimicron,3037 TT,買入評級):長期以來,欣興電子是博通、美滿電子(Marvell,MRVL.US,未評級)和英偉達的關鍵基板合作伙伴。野村認爲,欣興電子也将成为 Meta、谷歌及 AWS ASIC 基板的主要供應商之一。此外,在英偉達 Blackwell AI GPU 業務中,預計其在 B200/300 產品上的份額達 30%-40%,將同步受益。

聯茂電子(EMC,2383 TT,買入評級): 是亞馬遜雲科技和 Meta ASIC 領域佔據主導地位的覆銅板(CCL)供應商。Meta ASIC PCB 對覆銅板要求極高(36/40 層,採用 M8 混合覆銅板 ),而亞馬遜雲科技 ASIC(24-26 層 M8 VCL )的需求同樣旺盛。鉴于聯茂電子在人工智能 ASIC 領域更高的單位價值量及市場份額,其將顯著受益。

滬電股份(WUS,002463.SZ,買入評級): 有望成爲 Meta ASIC 的主要印刷電路板(PCB)供應商。儘管 Meta 項目中還有其他 PCB 製造商,但 Meta PCB 的超高層數規格是勝宏科技的優勢 —— 其層數和結構與 800G 交換機類似,滬電股份在技术和产能上具备实力。

野村還預計,基板管理控制器(BMC)將從 Meta ASIC 人工智能服務器開發中受益。原因在於,每個機架的 BMC 單元含量可能增加,更重要的是,MTIA 刀片服務器中會額外使用一層迷你 BMC。據 BMC 供應商估算,一個 MTIA 服務器機架包含 23 個 BMC,其中 16 個在 MTIA 刀片中,6 個在网络刀片中,1 個在机架管理刀片中,此外 MTIA 刀片中還有 16 個迷你 BMC。

野村認爲,Bizlink(3665 TT,買入評級)將從 MTIA 服務器的規模化擴展 / 升級連接中顯著受益。Bizlink 是全球領先的有源電纜(AEC)供應商,其 AEC 產品廣泛應用於多家超大規模雲計算服務商(CSP)的 ASIC 服務器,如 AWS、超微(XAL)和廣達,用於大規模擴展場景。值得注意的是,该供應商计划在 2026 年推出 PCIe AEC,以挖掘不断增长的人工智能服務器规模化市场。在 Meta 的機架設計中, Bizlink 的 AEC 有望應用於規模化擴展(機架到交換機)和升級(機架內部)場景,也可能用於電源線。