FOREXBNB获悉,野村发布研报称,在AI服务器领域,英伟达迄今为止占据了超过80%的市场价值份额,而ASIC AI服务器的价值份额约为8%-11%。另据供应链反馈显示,更多的云服务提供商(CSP)正在更积极地部署自己的 AI ASIC 解决方案,例如 Meta(META.US)从2026年开始,微软(MSFT.US)从2027年开始。随着超大规模云服务提供商内部需求的成熟(这是特定领域的需求),云ASIC仍有增长空间,这将挑战英伟(NVDA.US)达在AI计算集群中的主导地位。

Meta主要的MTIA项目(尤其是V1.5版本)仍处于开发早期阶段,存在诸多不确定性。从供应链处了解到,Meta计划到 2026年大规模推进部署,但能否克服上述潜在挑战尚不明朗。不过,从投资角度看,考虑到当前人工智能行业趋势(计算能力提升、连接速度加快、功率和热管理要求提高等),建议布局多元化客户覆盖的潜在受益企业,包括英伟达、AWS Trainium、Meta MTIA 以及谷歌 TPU相关供应链。

野村主要观点如下:

野村发布研究报告指出,Meta的 MTIA AI服务器可能成为 2026 年的一个里程碑。

AI ASIC 正蓬勃发展:2026 年下半年至 2027 年有望实现出货量的超越

在 AI 服务器领域,英伟达(NVDA.US)迄今为止占据了超过 80% 的市场价值份额,而 ASIC AI 服务器的价值份额约为 8%-11%(基于彭博社的共识估计)。然而,如果仅比较 AI ASIC 与英伟达 AI GPU 的出货量(这可以排除英伟达高达 70-80% 的毛利率所导致的价值偏差),根据供应链调查和野村的分析,2025 年,谷歌的 TPU 可能达到 150 万至 200 万台,亚马逊的 Trainium2 ASIC 可能约为 140 万至 150 万台,而英伟达准备的 AI GPU 供应量在 2025 年为 500 万至 600 万台以上(实际销量可能低于供应量)。

2025 年,谷歌和亚马逊的 AI TPU/ASIC 的合计出货量已达到英伟达 AI GPU 出货量的 40%-60%。

野村的供应链反馈还显示,更多的云服务提供商(CSP)正在更积极地部署自己的 AI ASIC 解决方案,例如 Meta(META.US)从 2026 年开始,微软从 2027 年开始。AI ASIC 的总出货量可能在 2026 年的某个时候超过英伟达的 AI GPU。

另一方面,野村注意到英伟达并未坐以待毙,任由定制芯片项目蚕食其市场份额,最终对其在云 AI 计算领域的主导地位造成重大影响。

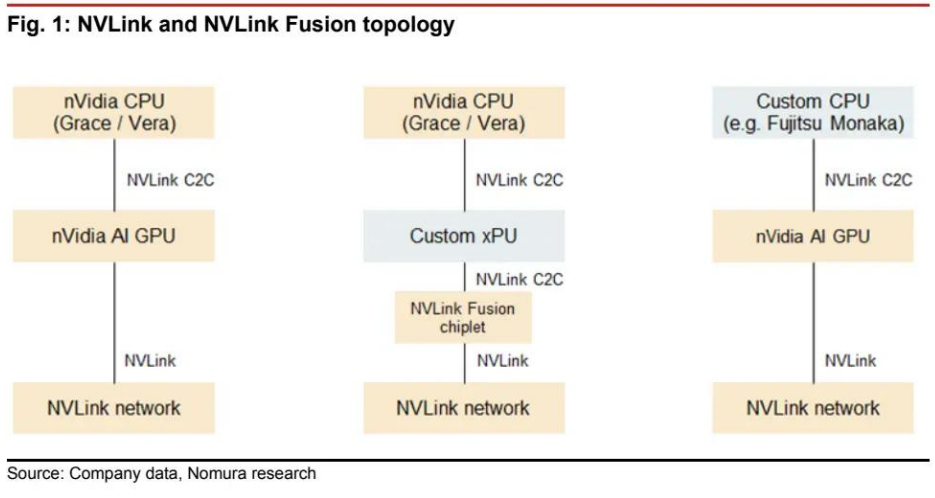

在 2025 年台北国际电脑展(COMPUTEX 2025)上,英伟达推出了 NVLink Fusion,该技术开放了专有互连协议,支持英伟达 AI GPU 与第三方 CPU 之间,或定制 xPU 与英伟达基于 ARM 的 CPU 之间的芯片间连接(图 1)。

尽管这种混合架构只是半定制化的,但英伟达正试图避免完全失去部分云计算市场,因此云客户的最终采用情况和反馈值得关注。

AI ASIC 解决方案对供应商可能意味着更多机会

英伟达在 AI 计算领域相对于包括云 ASIC 在内的其他 AI 加速器的领先优势正在扩大,部分原因在于:

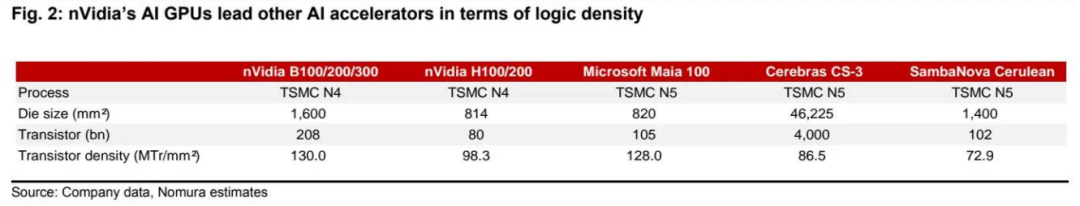

(1)英伟达的产品在单位芯片面积的计算能力(与逻辑密度相关;图 2)方面可能优于大多数竞争对手的产品。根据阅存对其产品路线图的研究,该公司正更加积极地带头采用其逻辑代工厂合作伙伴台积电(TSM.US)(2330 TT,买入评级)的新技术。

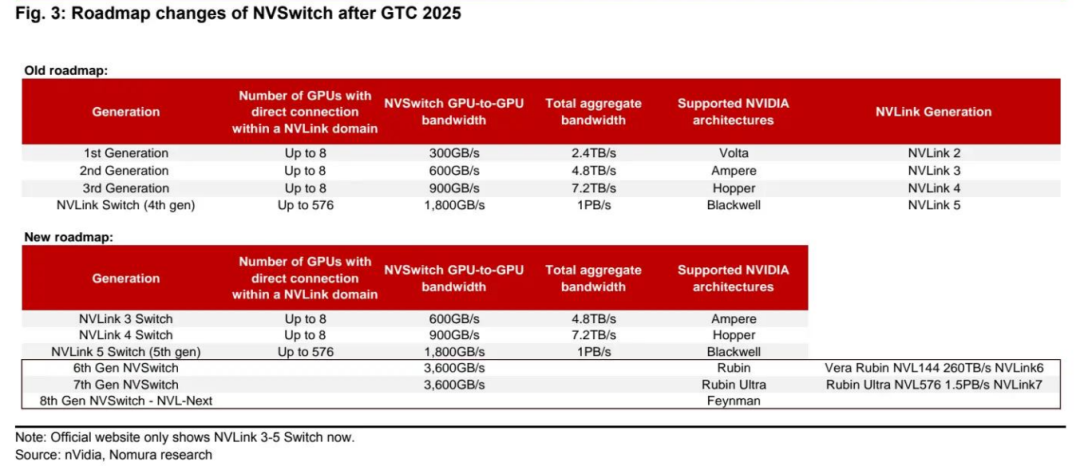

(2)英伟达用于 AI 集群扩展的互连技术(NVLink)几乎无可匹敌。野村认为,尽管业界正在寻求开放规格的 UALink,但到 2026-2027 年,其架构性能仍无法赶上英伟达(图 3)。

野村注意到,为了弥补技术性能的不足,与英伟达的解决方案相比,初始的 ASIC 解决方案往往使用更好的材料、组件和效率较低的架构,以确保系统稳定性和性能。这对供应商的附加值有利。然而,尽管物料清单(BOM)成本结构较高,但鉴于 ASIC 解决方案的定制化特性以及消除了英伟达的高系统利润率,对于云服务提供商自身的使用而言,ASIC 解决方案可能仍然更具成本效益。

野村认为,随着超大规模云服务提供商内部需求的成熟(这是特定领域的需求),云 ASIC 仍有增长空间,这将挑战英伟达在 AI 计算集群中的主导地位。

野村一直预计,2026 年台积电的 AI 逻辑半导体收入池中,定制 AI 加速器的增长将比商用 GPU 更为强劲。

迄今为止,野村的供应链反馈继续支持这一观点,但 AI ASIC 的发展正以更积极的姿态拥抱更复杂的规格(例如,用于子系统集成的更大中介层),这超出了市场预期,带来了惊喜。

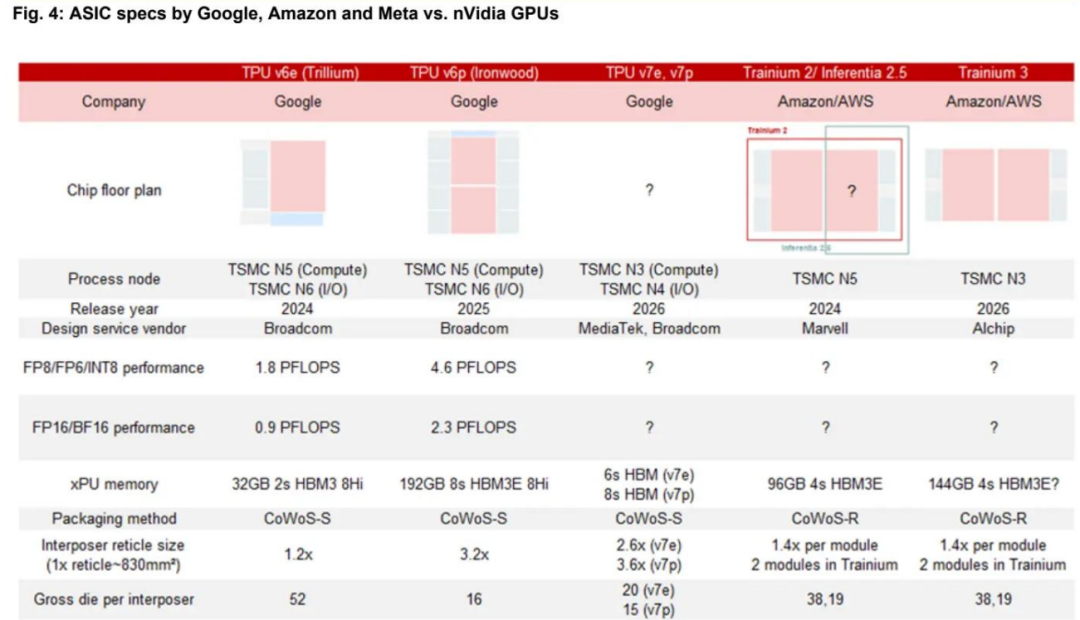

已宣布的 ASIC 项目,如亚马逊的 Trainium 和微软的 Maia 100,过去的特点是 HBM 存储立方体堆叠数量较少,中介层也比英伟达的 AI GPU 更小(大多不超过 2.5 倍光罩尺寸),但谷歌的 TPU 除外,其设计合作伙伴博通长期以来一直是推动台积电技术路线图创新的关键客户。

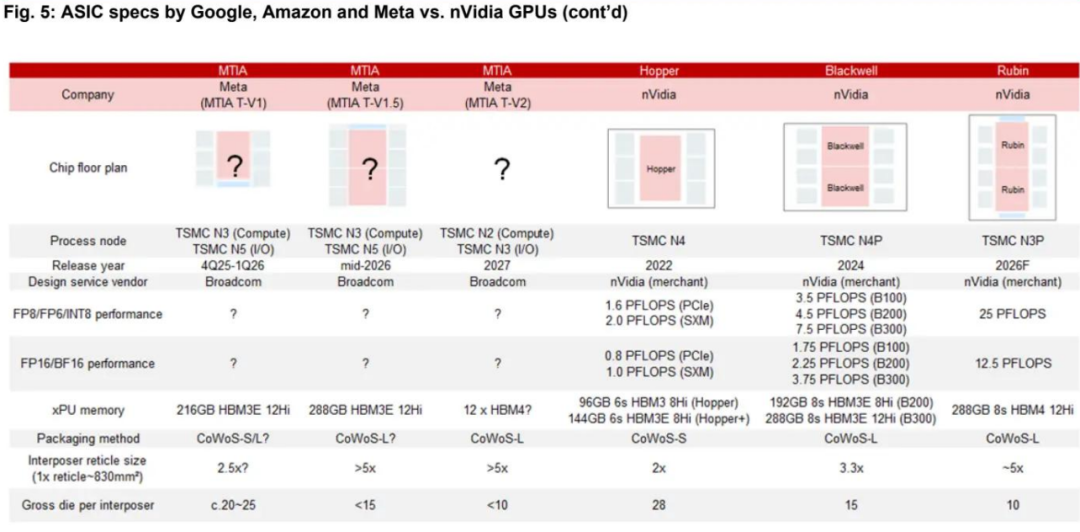

目前,野村观察到 AI ASIC 的规格正在追赶英伟达(图 4 和图 5),但英伟达在集群扩展连接性、集群外连性以及专有的 CUDA 生态系统(最适合企业专属 AI 解决方案)方面仍具有优势。

野村还注意到,一些 ASIC 解决方案(例如 Meta 的方案)正试图利用英伟达的系统架构,有些甚至计划在未来几年推出更激进的 ASIC 规格。

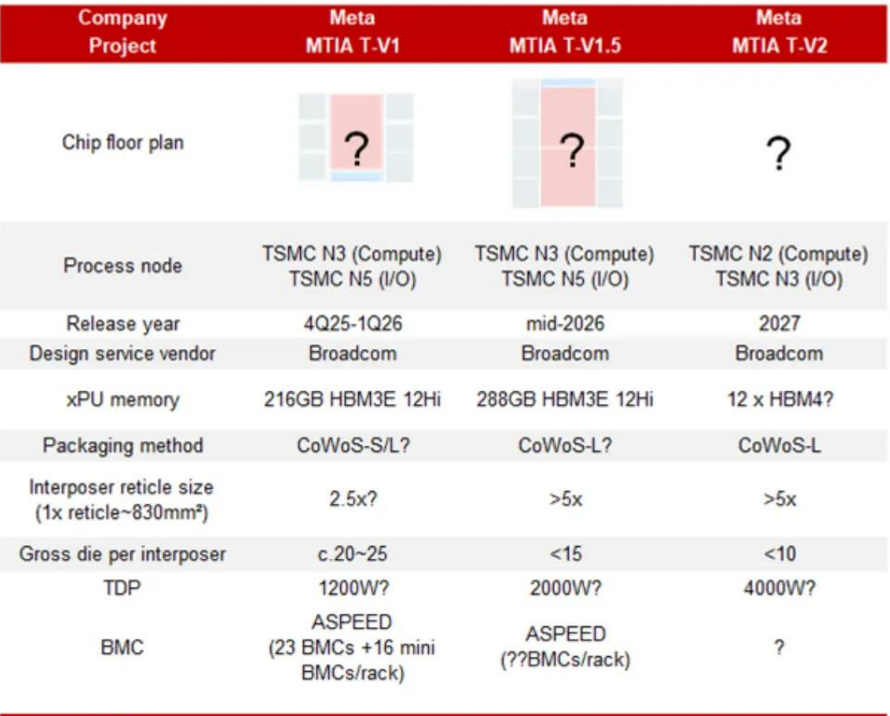

Meta 的 ASIC AI(MTIA)服务器可能在 2026-2027 年以有意义的方式实现规模化部署

野村过去曾强调,Meta 将在 2025 年底前推出首款具有可观出货量的 ASIC。现在,野村对其计划有了更多细节。野村观察到 Meta 从 2025 年底到 2027 年将推出几款具有不同系统架构的 MTIA 芯片。在下图中总结了这些 ASIC 和系统的规格。

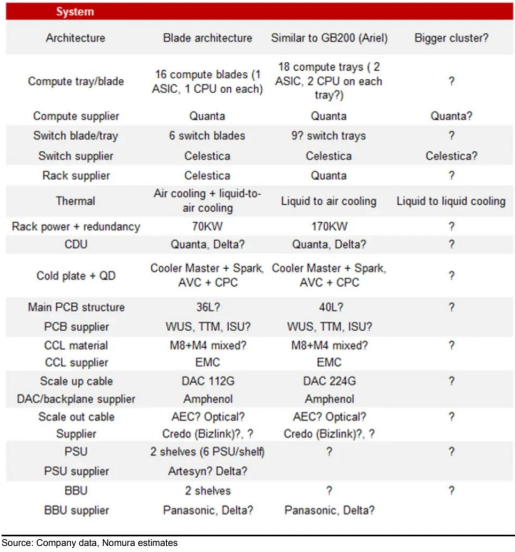

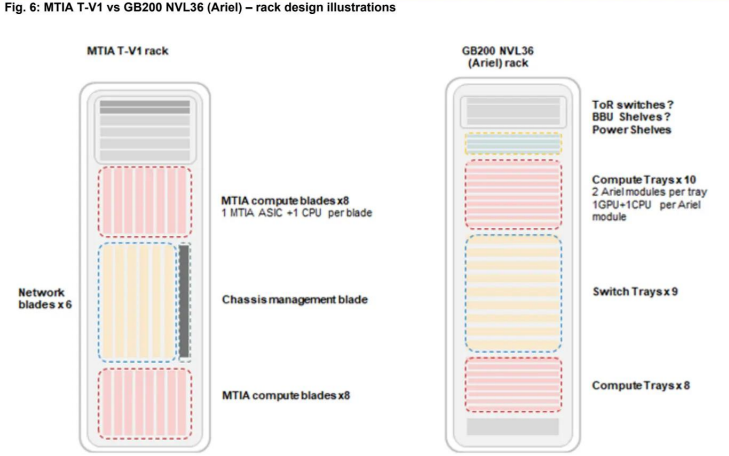

下一款 AI ASIC(MTIA T-V1)将于 2025 年第四季度推出,由博通设计,其中介层尺寸与亚马逊的 Trainium 2 相似或略小。野村观察到 Meta 正在利用其在通用服务器中的刀片架构来设计这款 AI ASIC 系统。供应链分析表明,该项目由天弘牵头,计算托盘和 CDU 由广达制造。机架设计如图 6 所示。16 个计算刀片和 6 个交换机刀片垂直插入 2 个电缆背板中,通过 DAC 连接。

主要的 ASIC 和交换机 IC 采用液冷,其余低功耗 IC 和模块采用风冷。尽管每个计算托盘中只有一个 ASIC 和一个 CPU,但 ASIC 主板的 PCB 设计复杂(尽管尺寸小),采用高等级材料(M8 混合 CCL)和高层数(例如 36 层),这可能是因为 ASIC 集成了更多功能,需要 PCB 中有更多的信号层,或者电源传输层被分离以确保更低的噪声。此外,可能还采用了 BBU 托盘。

MTIA T-V1.5(V1.5)ASIC 可能在 2026 年中期推出,系统在 2026 年下半年实现规模化部署。MTIA T-V1.5 的芯片性能可能比 V1 强大得多,其中介层尺寸可能是 V1 的两倍,超过 5 倍光罩尺寸,与英伟达的下一代 GPU Rubin 相似或稍大。尽管 MTIA T-V1.5 系统仍处于采样初期,但其系统架构更类似于 Meta 的 GB200(NVL36,使用 Arial 模块 —— 一个 GPU 和一个 CPU,而不是 Bianca—— 两个 GPU 和一个 CPU)。这解释了为什么 Meta 坚持在 GB200 中使用 Arial 模块,因为其单节点、相互备份的架构与之前讨论的刀片概念相似。渠道调查显示,Meta 可能会将 GB200 的组件和设计应用于 V1.5 ASIC 系统。

野村观察到,作为 Meta GB200 主要 ODM 厂商的广达,正在牵头这个 ASIC 项目,负责计算托盘、机架和 CDU,而天弘可能负责交换机。鉴于 ASIC 的设计更加复杂,计算主板的 PCB 层数可能高达 40 层 HLC PCB,采用混合 M8 CCL(而 Trainium2 主板仅为 24-26 层 M8 HLC PCB,英伟达采用 M8+M4 混合 HDI+5 层结构)。由于 V1.5 系统的计算托盘和交换机托盘水平放置,其集群扩展连接性通过 DAC 实现,就像 NVLink Spines 一样,无需背板箱。V1.5 和 V1 机架均采用液冷转风冷设计,野村认为它们与 GB200 和 GB300 共享相同的 CDU 设计和基础设施,因此 Meta 可以更灵活地在同一基础设施中安装不同的系统。

MTIA T-V2 ASIC 可能在 2027 年推出,其 CoWoS 封装尺寸可能比 MTIA T-V1.5 更大。机架系统可能比 MTIA T-V1.5 机架系统(170 千瓦)大得多。野村认为,如此高功率的系统可能需要液冷转液冷的冷却方式。

元平台 MTIA 的产量 —— 雄心与潜在挑战

在博通最新的财报电话会议上,博通重申了至少有三家超大规模客户预计到 2027 年底将部署 100 万套 xPU 集群的预期。

下游供应链也认为,元平台的目标是到 2025 年末至 2026 年,MTIA V1 和 V1.5 的产量达到 150 万套,且 V1.5 的产量将远高于 V1。假设 V1 和 V1.5 的产量分配比例为 1:2,即 V1 产量为 50 万套,V1.5 产量为 100 万套(野村的假设是为了简化计算),那么 2026 年 MTIA 总产量 200 万套所需的 CoWoS 晶圆约为 8.5 万片(主要用于 TPU),这与博通 2025 年 CoWoS 晶圆的可见需求大致相当。

然而,从当前情况看,野村预计 2026 年 MTIA 最多只能分配到约 3 - 4 万片 CoWoS 晶圆。要实现 100 万套以上的产量目标,需要在下游供应链中看到更多的 CoWoS 晶圆预订。

MTIA 还面临其他潜在挑战。鉴于 ASIC V1.5 的激进规格,其 CoWoS 封装尺寸较大,这可能是其量产过程中最大的挑战之一。不确定其大尺寸是否会导致 CoWoS 基板出现问题。更不用说 V1.5 系统在计算功率密度方面与配备博通连接芯片和元平台架构的 GB200 NVL36 相当。不清楚元平台是否有足够时间将系统(包括至少 6 - 9 个月的材料爬坡时间)量产。此外,正如之前强调的,如果 ASIC 为了弥补性能差距而倾向于使用更好的材料和组件,当 MTIA 大规模量产,且如下游供应商所说的那样对 AI 晶圆厂(fabs)需求旺盛时,下游材料和组件可能会出现潜在短缺,而这些材料和组件通常也用于 AI GPU 和 ASIC。

投资观点:

广达、欣兴电子、联茂电子、胜宏科技和 Bizlink 是 Meta MTIA 项目的潜在关键受益者

野村认为,Meta 主要的 MTIA 项目(尤其是 V1.5 版本)仍处于开发早期阶段,存在诸多不确定性。从供应链处了解到,Meta 雄心勃勃,计划到 2026 年大规模推进部署,但能否克服上述潜在挑战尚不明朗。不过,从投资角度看,考虑到当前人工智能行业趋势(计算能力提升、连接速度加快、功率和热管理要求提高等),建议布局多元化客户覆盖的潜在受益企业,包括英伟达、AWS Trainium、Meta MTIA 以及谷歌 TPU 相关供应链。

对于此前未受充分关注的 Meta 项目,在野村的覆盖范围内,广达、欣兴电子、联茂电子、胜宏科技和 Bizlink 是关键受益者:

广达(Quanta): 作为亚马逊云科技(AWS)、谷歌及 Meta GB200/300 项目的主要原始设计制造商(ODM),广达还负责 Meta MTIA V1 和 V1.5 的计算托盘及 CDU(冷却分配单元 )制造,且主导 MTIA V1.5 的整机架组装。其在英伟达及 ASIC 解决方案领域的多元化布局,有望助力该公司实现业务再增长。

欣兴电子(Unimicron,3037 TT,买入评级):长期以来,欣兴电子是博通、美满电子(Marvell,MRVL.US,未评级)和英伟达的关键基板合作伙伴。野村认为,欣兴电子也将成为 Meta、谷歌及 AWS ASIC 基板的主要供应商之一。此外,在英伟达 Blackwell AI GPU 业务中,预计其在 B200/300 产品上的份额达 30%-40%,将同步受益。

联茂电子(EMC,2383 TT,买入评级): 是亚马逊云科技和 Meta ASIC 领域占据主导地位的覆铜板(CCL)供应商。Meta ASIC PCB 对覆铜板要求极高(36/40 层,采用 M8 混合覆铜板 ),而亚马逊云科技 ASIC(24-26 层 M8 VCL )的需求同样旺盛。鉴于联茂电子在人工智能 ASIC 领域更高的单位价值量及市场份额,其将显著受益。

沪电股份(WUS,002463.SZ,买入评级): 有望成为 Meta ASIC 的主要印刷电路板(PCB)供应商。尽管 Meta 项目中还有其他 PCB 制造商,但 Meta PCB 的超高层数规格是胜宏科技的优势 —— 其层数和结构与 800G 交换机类似,沪电股份在技术和产能上具备实力。

野村还预计,基板管理控制器(BMC)将从 Meta ASIC 人工智能服务器开发中受益。原因在于,每个机架的 BMC 单元含量可能增加,更重要的是,MTIA 刀片服务器中会额外使用一层迷你 BMC。据 BMC 供应商估算,一个 MTIA 服务器机架包含 23 个 BMC,其中 16 个在 MTIA 刀片中,6 个在网络刀片中,1 个在机架管理刀片中,此外 MTIA 刀片中还有 16 个迷你 BMC。

野村认为,Bizlink(3665 TT,买入评级)将从 MTIA 服务器的规模化扩展 / 升级连接中显著受益。Bizlink 是全球领先的有源电缆(AEC)供应商,其 AEC 产品广泛应用于多家超大规模云计算服务商(CSP)的 ASIC 服务器,如 AWS、超微(XAL)和广达,用于大规模扩展场景。值得注意的是,该供应商计划在 2026 年推出 PCIe AEC,以挖掘不断增长的人工智能服务器规模化市场。在 Meta 的机架设计中, Bizlink 的 AEC 有望应用于规模化扩展(机架到交换机)和升级(机架内部)场景,也可能用于电源线。